Arquivo

Quasar tem o maior depósito de água do Universo

A água, o equivalente a 140 trilhões de vezes toda a água dos oceanos da Terra, está ao redor de um enorme buraco negro.

Duas equipes de astrônomos descobriram o maior e mais distante reservatório de água já detectado no universo.

A água, o equivalente a 140 trilhões de vezes toda a água dos oceanos da Terra, está ao redor de um enorme buraco negro do tipo quasar, a mais de 12 bilhões de anos-luz de distância.

“O ambiente em torno deste quasar é único na medida que está produzindo essa enorme massa de água”, disse Matt Bradford, cientista do Laboratório de Propulsão a Jato da NASA. “É mais uma demonstração de que a água está presente em todo o universo, mesmo nos tempos mais antigos.”

Quasar – Um quasar é alimentado por um enorme buraco negro que consome de forma constante um disco de gás e poeira ao seu redor. Conforme consome essa matéria, o quasar expele grandes quantidades de energia.

Os dois grupos de astrônomos estudaram um quasar chamado APM 08279+5255, que abriga um buraco negro 20 bilhões de vezes mais maciço do que o Sol e produz uma quantidade de energia equivalente a mil trilhões de sóis.

Os astrônomos já esperavam que o vapor de água estivesse presente no universo primordial, mas nunca tinham detectado essa água tão longe antes. Há vapor de água na Via Láctea, embora a quantidade total seja 4.000 vezes menor do que no quasar agora estudado, porque a maioria da água da Via Láctea está na forma de gelo.

O vapor de água é importante para revelar a natureza do quasar. Neste quasar em particular, o vapor de água está distribuído ao redor do buraco negro em uma região gasosa que abrange centenas de anos-luz de tamanho.

Sua presença indica que o quasar está inundando o gás ao seu redor com raios-X e radiação infravermelha, e que o gás é extremamente quente e denso mesmo para os padrões astronômicos.

Ainda que “quente e denso” seja algo muito relativo: o gás está a -53 grau Celsius e é 300 trilhões de vezes menos denso do que a atmosfera da Terra.

Apesar disso, ele é cinco vezes mais quente entre 1 e 10 vezes mais denso do que o gás típico de galáxias como a Via Láctea.

Medições do vapor de água e de outras moléculas, como o monóxido de carbono, sugerem que há gás suficiente para alimentar o buraco negro até que ele cresça até seis vezes seu tamanho atual.

Se isso vai ou não acontecer não está claro, afirmam os astrônomos, uma vez que parte do gás pode acabar condensando-se em estrelas, ou pode ser expulso do quasar.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=maior-deposito-agua-do-universo&id=010175110724&ebol=sim

2011 07 26

Bateria de lítio transparente

Os cientistas usaram o máximo de materiais transparentes que é possível e miniaturizaram o que ainda é opaco o suficiente para enganar os olhos humanos. (.inovacaotecnologica)

O Dr. Yi Cui e seus colegas da Universidade de Stanford usaram o máximo de materiais transparentes que é possível e miniaturizaram o que ainda é opaco o suficiente para enganar os olhos humanos.

“Se alguma coisa é menor do que 50 micrômetros, seus olhos a verão como algo transparente,” diz Yuan Yang, que foi quem colocou a mão na massa para construir a bateria.

O olho de uma pessoa “normal” tem uma resolução suficiente para enxergar objetos entre 50 e 100 micrômetros.

Em vez dos eletrodos tradicionais, que são opacos, Yang e Cui construíram um eletrodo com uma malha na qual cada fio tem aproximadamente 35 micrômetros de largura.

A luz consegue passar através dos buracos da malha. E, como o olho humano não consegue ver os próprios fios, toda a bateria parece ser transparente.

A estrutura da bateria usa um polímero transparente, o polidimetilsiloxano, usado na fabricação de lentes de contato e de circuitos eletrônicos flexíveis.

Primeiro os cientistas criaram as trilhas de 35 micrômetros em uma folha do polímero transparente, sobre o qual é depositado um filme metálico por evaporação, criando uma camada condutora.

Essa camada condutora é fina o suficiente para não se tornar opaca.

A seguir, uma solução contendo nanopartículas do material que armazena energia – à base de lítio – é depositada para preencher as trilhas, formando a malha.

Faltava ainda o separador entre os eletrodos. Os pesquisadores substituíram os separados tradicionais, que não são transparentes, por um eletrólito em gel que funciona tanto como eletrólito quanto como separador.

Colocando-se com precisão uma camada de eletrólito entre duas camadas com os eletrodos cria-se uma bateria, que pode ainda ser construída em várias camadas, para aumentar a capacidade de carga.

A precisão na montagem é crucial, uma vez que as trilhas de 35 micrômetros das diversas camadas devem se sobrepor perfeitamente, sob pena de perder-se a “pseudo-transparência” – com três camadas, os pesquisadores conseguiram uma transparência de 60%.

A transparência também tem seu custo: a bateria tem apenas metade da densidade de carga de uma bateria de lítio convencional, ficando próximo às baterias de níquel-cádmio.

Como há um potencial real de comercialização, os pesquisadores patentearam o projeto da bateria transparente e, agora, vão trabalhar na melhoria de sua densidade de energia.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=bateria-litio-transparente&id=010115110726&ebol=sim

2011 07 26

Fótons não ultrapassam velocidade da luz

Uma equipe de físicos da Universidade de Hong Kong afirma ter conseguido uma medição direta do precursor óptico de um único fóton, demonstrando que fótons individuais não podem viajar mais rápido do que a luz no vácuo.

O estudo reafirma a teoria de Einstein de que nada viaja mais rápido do que a velocidade máxima da luz e fecha um debate de uma década sobre a velocidade de um fóton individual.

Para Einstein, nada pode viajar mais rápido do que a velocidade máxima da luz.

Mas esta é a primeira demonstração experimental de que os chamados precursores ópticos – uma espécie de parte frontal da onda de luz, sua porção que viaja mais rapidamente – existem ao nível dos fótons individuais e que eles são, como se previa, a parte mais rápida do pacote de onda, mesmo em um meio superluminal.

Ou seja, se há alguém que realmente atinge a famosa velocidade máxima c – de 299.792.458 m/s – esse alguém é o precursor óptico.

“Os resultados ampliam nosso entendimento de como um fóton individual se move. Eles também confirmam o limite máximo de velocidade que uma informação pode ser transportada com luz,” afirmou Shengwang Du, coordenador do estudo.

“Ao mostrar que os fótons individuais não podem viajar mais rápido do que a velocidade da luz, nossos resultados encerram o debate sobre a verdadeira velocidade da informação transportada por um único fóton. Nossas conclusões também poderão dar aos cientistas um quadro melhor sobre a transmissão da informação quântica,” completou.

Quanto a “encerrar o debate”, talvez seja melhor um pouco de prudência, uma vez que o experimento contém muitos pressupostos que podem ser discutidos. Para se ter uma ideia, em 2010, um grupo de pesquisadores alemães fez um experimento diferente e chegou à conclusão oposta.

Há cerca de 10 anos, a descoberta de uma propagação superluminal – acima da velocidade da luz – causou sensação ao levantar a possibilidade da viagem no tempo. Mas só até que a diferença entre a velocidade de fase e a velocidade de grupo fosse devidamente explicada.

O que ocorre é que a propagação daqueles pulsos ópticos em alguns meios específicos era apenas um efeito visual – a velocidade superluminal de um grupo de fótons não poderia ser usada para transmitir qualquer informação real.

As esperanças foram então para os fótons individuais, porque a partícula quântica fóton parece poder viajar mais rápido do que o limite da velocidade da luz no mundo clássico.

Foi isto o que o Dr. Shengwang Du quis checar, medindo a velocidade máxima de um fóton individual.

Sua conclusão é que os fótons individuais obedecem às regras de trânsito da relatividade, confirmando a causalidade de Einstein, ou seja, que um efeito não pode ocorrer antes de sua causa – e isto joga por terra a possibilidade teórica da viagem no tempo que havia sido levantada com base na velocidade superluminal.

Isto não significa, porém, que o experimento “provou que a viagem no tempo é impossível” – ele demonstra que não é possível viajar no tempo superando o limite de velocidade do universo com uma nave para fazer o tempo encolher.

É verdade que esta seria a forma “mais fácil” de viajar no tempo – ao menos para fótons.

Mas ainda restam esperanças para os visionários e curiosos sobre o passado e o futuro.

A teoria da relatividade continua aceitando a possibilidade de uma dobradura no contínuo do espaço-tempo para chegar aonde você já esteve antes – bastará ter uma massa suficiente, e controlável, para fazer isso.

Algo bastante difícil, mas tampouco seria fácil entrar em uma nave do tamanho de um fóton.

Há também sugestões menos ortodoxas, baseadas na Teoria M, mas testáveis experimentalmente.

A pesquisa abre outra possibilidade interessante: como o fóton individual é considerado como uma entidade que tem uma porção frontal – o precursor óptico – que viaja mais rápido, isso significa que ele possui uma dimensão não-zero.

Assim, embora você não possa voltar no tempo, pode ser possível criar um hiato entre a causa e o efeito, modulando o comprimento do fóton como um todo.

Se você abstrair das incrivelmente pequenas frações de tempo envolvidas, será possível ver “causas” que parecem não gerar efeitos, e “efeitos” que aparentemente saem do nada, quando todos já se esqueceram da sua “causa”.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=viagem-tempo-fotons-velocidade-luz&id=010130110726&ebol=sim

2011 07 26

KDE vs GNOME: Disputa pelo termo ‘System Settings’

Ben Cooksley, o mantenedor do System Settings do KDE pediu formalmente ao pessoal do GNOME que deixem de usar esse nome, exigindo que troquem o nome do configurador do GNOME para outra coisa que não entre em conflito. E pediu isso “imediatamente”, em tom ameaçador.

A discussão está em kde-core-devel (http://lists.kde.org/?l=kde-core-devel&m=131132292207915&w=2) mas foi postada também no veículo GNOME em http://mail.gnome.org/archives/desktop-devel-list/2011-July/msg00021.html).

Nas versões recentes, especialmente com o GNOME 3, o painel de controle em inglês leva o nome “System Settings”, termo que já era usado pelo KDE.

O ponto de vista apresentado na lista até pode ter razão, uma vez que isso pode causar problemas para os usuários em ambientes com KDE e GNOME instalados: a entrada do menu igual para os dois. Alguns empacotadores de distros ou admnistradores de sistemas poderiam bloquear o item do menu do KDE 4 onde o GNOME fosse o padrão, impedindo – ou dificultando – que muitos usuários alterassem as configurações de aplicativos do KDE.

A discussão continua rolando em busca de alguma solução pacífica. Diferente dos casos de grandes empresas, pelo menos essa não deve acabar num tribunal. A abordagem da mensagem inicial é que prejudicou o começo da discussão, algo raro no mundo do SL vindo dos representantes oficiais dos projetos.

Fonte: http://www.hardware.com.br/noticias/2011-07/gnome-kde-system-settings.html e Internet, http://lists.kde.org/?l=kde-core-devel&m=131132292207915&w=2, http://mail.gnome.org/archives/desktop-devel-list/2011-July/msg00021.html

2011 07 26

Acelerador acha partícula parente do nêutron

Acelerador de partículas dso Estados Unidos detecta parente do nêutron previsto por cientistas, mas nunca antes observado.

Em um anúncio feito hoje pelo físico Pat Lukens, do Laboratório Nacional Fermi, foi confirmada a observação da particular chamada Xi-sub-b.

Sua existência havia sido prevista no Modelo Padrão da física, porém ela nunca havia sido detectada devido à dificuldade envolvida no processo: ela é rara e produzida somente em colisões de grande energia, envolvendo outras partículas maiores. Além disso, viaja apenas uma fração de milímetro antes de decair.

Para se ter uma ideia, o Tevatron, do Fermi, o segundo maior acelerador de partículas do mundo, realizou 500 trilhões de colisões próton-antipróton para obter 25 resultados que pudessem ser avaliados e confirmassem a observação.

A partícula Xi-sub-b é neutra, formada por três quarks: um “strange”, um “up” e um “down”. Ela é cerca de seis vezes mais pesada do que um próton ou nêutron.

Os quarks são as chamadas partículas elementares- o que significa que não podem ser divididos. Para por em perspectiva, vale lembrar que os átomos são formados por partículas pesadas como prótons e nêutrons. Essas partículas recebem o nome de hádrons e, por sua vez, são formadas por diferentes combinações de quarks. Existem seis tipos de quarks e são eles que determinam a carga de uma partícula (positiva, negativa, ou neutra).

Há os “ups” (de carga +2/3), os “downs” (carga -1/3), “charmed” (carga +2/3), “strange” (-1/3), “top” (+2/3) e “bottom” (-1/3). O próton, por exemplo, possui dois quarks “up” e um “down”. Sua carga é, portanto, +1. Por essa mesma conta, a Xi-sub-b (um “strange”, um “up” e um “down”) é neutra.

Medir as propriedades dessas partículas é uma forma de testar e aprimorar o Modelo Padrão. É também uma importante descoberta para o FermiLab, que luta para tentar manter seu acelerador Tevatron funcionando.

Fonte: infoabril

2011 07 22

Atlantis retorna e encerra programa da NASA

O ônibus espacial Atlantis voltou para casa nesta quinta-feira (22/07/2011), atravessando um céu iluminado pela lua para completar uma missão de 13 dias na Estação Espacial Internacional e encerrar uma odisseia de 30 anos para o programa de ônibus espaciais da Nasa.

O comandante Chris Ferguson pilotou suavemente a nave espacial de 100 toneladas às alturas, e então mergulhou de frente rumo à faixa de pouso rodeada por pântanos no Centro Espacial Kennedy, alguns quilômetros do local onde o Atlantis será exposto como uma peça de museu.

O comandante Chris Ferguson pilotou suavemente a nave espacial de 100 toneladas às alturas, e então mergulhou de frente rumo à faixa de pouso rodeada por pântanos no Centro Espacial Kennedy, alguns quilômetros do local onde o Atlantis será exposto como uma peça de museu.

Explosões sônicas abalaram o silêncio da madrugada ao redor do centro espacial, a última vez que os moradores irão ouvir o som de uma nave voltando para casa.

Ferguson conduziu o Atlantis para a pista de pouso às 5h57 (6h57, horário de Brasília), encerrando uma jornada de 8,4 milhões de quilômetros e fechando um capítulo na história de voos espaciais humanos.

“Missão completa, Houston”, disse Ferguson via rádio ao Controle da Missão.

O astronauta Barry Wilmore, do posto de controle, respondeu: “Usaremos essa oportunidade para parabenizá-lo Atlantis, e os milhares de indivíduos apaixonados de toda essa grande nação que realmente deram força à essa incrível nave espacial, que durante três décadas inspirou milhões pelo mundo.”

O retorno do Atlantis de sua 135a missão encerrou o programa de 30 anos, e apesar de as missões aparentarem ser de rotina, dois acidentes fatais mataram 14 astronautas e destruíram duas das cinco naves espaciais da Nasa durante esse período.

Fonte: internet

2011 07 22

Ministro das Comunicações vê queda de preços para banda larga

O início do plano de Internet banda larga do governo deve gerar um aumento na oferta do serviço suficiente para pressionar as empresas a cobrarem valores abaixo dos previstos, afirmou o ministro das Comunicações, Paulo Bernardo, nesta quinta-feira.

“A minha previsão, com toda a sinceridade, é que as empresas não vão conseguir vender a 35 reais (por 1 megabit/segundo), porque vai ter mais oferta. Provavelmente vão ter de baixar (o preço) ou aumentar a velocidade pelo mesmo preço”, disse Bernardo, no programa de rádio do governo “Bom Dia Ministro”

Segundo Bernardo, apenas 27 por cento dos domicílios brasileiros têm acesso à Internet e nos próximos 60 dias empresas que firmaram contratos para participar do Plano Nacional de Banda Larga (PNBL) deverão começar a oferecer a conexão de velocidade de 1 Mbit/s por 35 reais.

O ministro comentou no programa que os planos do governo devem exigir investimentos de 10 bilhões de reais em infraestrutura até 2014 e que o ministério está avaliando a construção de pelo menos mais um cabo submarino internacional de comunicações de forma a preparar a rede brasileira para o esperado aumento de demanda de tráfego de dados.

“Já temos propostas para construir um para a América do Norte e outro para a Europa, para atender à demanda.”

Para a Copa do Mundo de 2014, Bernardo afirmou que os investimentos vão incluir velocidade ultrarápidas de acesso à Internet (de 50 Mbit/s a 100 Mbit/s) de Internet nas cidades-sede. “Vai ser preciso escala industrial e estamos planejando isso para fazermos o provimento dessa infraestrutura a tempo para a Copa.”

Pelo PNBL, a estatal de comunicações Telebrás planeja construir uma ampla rede de fibra ótica em todo o Brasil para fornecer infraestrutura de banda larga a provedores de Internet e operadoras de telefonia. No começo de junho, a Telebrás assinou seu primeiro contrato de banda larga dentro do PNBL, com o provedor local de acesso Sadnet, em Santo Antônio do Descoberto (GO).

As operadoras Oi, Telefônica, TIM, CTBC e Sercomtel também vão participar do Plano Nacional de Banda Larga (PNBL).

Fonte: http://info.abril.com.br/noticias/tecnologia-pessoal/ministro-ve-queda-de-precos-para-banda-larga-21072011-3.shl em 21 de julho de 2011 – 10h13

2011 07 22

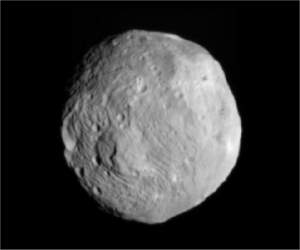

Sonda da NASA entrará em órbita do asteroide Vesta

Esta é uma das últimas imagens captadas pela sonda Dawn, quando estava a 41.000 km de distância do asteroide Vesta.

A sonda Dawn (Aurora) vai começar um longo e aguardado encontro com o asteroide Vesta, tornando a missão a primeira a entrar em órbita em torno de um dos muitos habitantes do Cinturão de Asteroides.

O Cinturão de Asteroides situa-se entre as órbitas de Marte e Júpiter.

A sonda Dawn vai estudar o Vesta durante um ano, e espera-se que as observações ajudem os cientistas a entender os primeiros capítulos da história do nosso Sistema Solar.

Há a possibilidade de o asteroide gigante, que tem cerca de 500 quilômetros de diâmetro, tenha suas próprias “luas”.

Os engenheiros esperam que a sonda seja capturada em órbita do asteroide por volta das 02h00 (horário de Brasília) da madrugada deste sábado (16). Mas a inserção correta só poderá ser confirmada quase 24 horas depois, já na madrugada de domingo.

“Levou cerca de quatro anos para chegar a este ponto,” disse Robert Mase, gerente do projeto. “Nossos últimos testes e checagens mostram que a Dawn está bem no alvo e funcionando normalmente.”

Ao contrário de outras missões, onde são usados disparos dos foguetes para colocar as naves em órbita em torno de um planeta, a Dawn vai tirar o pé do acelerador, esperando que a gravidade do asteroide a capture em sua órbita.

Depois de estudar o Vesta, a Dawn partirá para seu segundo destino, o planeta-anão Ceres, em julho de 2012.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=sonda-nasa-orbita-asteroide-vesta&id=010175110715&ebol=sim

2011 07 21

Rotação da galáxia pode explicar disparidade entre matéria e antimatéria

Um físico da Universidade de Warwick, no Reino Unido, produziu uma solução de dimensões galácticas para explicar um dos mais desafiadores quebra-cabeças da física atual.

E a solução ainda deixa uma porta aberta para explicar o enigma do “desaparecimento” da antimatéria que deve ter sido criada no surgimento do nosso Universo.

Os físicos adorariam um universo bem-comportado, onde as leis da física fossem tão universais que cada partícula e sua antipartícula se comportassem da mesma maneira.

No entanto, nos últimos anos, observações experimentais de partículas conhecidas como kaons e mésons B revelaram diferenças significativas na forma como a matéria e a antimatéria decaem.

Esta “violação da paridade de carga”, ou “violação de CP”, é uma anomalia inconveniente para alguns pesquisadores, mas é um fenômeno útil para outros, já que pode abrir o caminho para uma explicação de por que mais matéria do que antimatéria parece ter sobrevivido ao nascimento do nosso universo.

Agora, o Dr. Mark Hadley, acredita ter encontrado uma explicação testável para a aparente violação da paridade de carga, uma explicação que não apenas preserva a paridade, mas também torna a violação da paridade de carga uma explicação ainda mais plausível para a divisão entre matéria e antimatéria.

O Dr. Hadley sugere que os pesquisadores têm negligenciado o impacto significativo da rotação da nossa galáxia no padrão de quebra das partículas atômicas.

“Segundo os pontos de vista aceitos na física de partículas, a natureza é fundamentalmente assimétrica. Existe uma clara assimetria da esquerda para a direita nas interações fracas e uma violação de CP bem menor em sistemas Kaon, que têm sido medidos, mas nunca explicados.

“Esta pesquisa sugere que os resultados experimentais em nossos laboratórios são uma consequência da rotação galáctica torcendo nosso espaço-tempo local.

“Se isso se mostrar correto, então a natureza seria, afinal de contas, fundamentalmente simétrica. Esta previsão radical é testável com os dados que já foram coletados no CERN [LHC] e [no experimento] BaBar, bastando olhar os resultados que foram distorcidos no sentido que a galáxia gira,” explica o Dr. Hadley.

Parece ser fácil negligenciar o efeito de algo tão grande quanto uma galáxia, porque o que parece mais óbvio para nós é o campo gravitacional local da Terra ou do Sol, sendo ambos muito mais facilmente perceptíveis do que o efeito gravitacional que nossa galáxia como um todo exerce sobre nós.

No entanto, o Dr. Hadley acredita que o que é mais importante neste caso é um efeito gerado pelo giro de tal corpo tão maciço.

A velocidade e o momento angular do giro de um corpo tão maciço quanto nossa galáxia cria um “arrastamento” sobre o espaço e o tempo locais, torcendo o formato desse tempo-espaço e criando efeitos de dilatação do tempo.

A rotação da nossa galáxia tem um efeito de torção no nosso espaço local que é um milhão de vezes mais forte do que a causada pela rotação da Terra.

Quando a violação de CP foi observada no decaimento dos mésons B, a diferença fundamental observada entre a dissolução das versões de matéria e de antimatéria da mesma partícula é uma variação nas diferentes taxas de decaimento.

Curiosamente, embora os pesquisadores observem essa larga variação no padrão das taxas de decaimento, quando as taxas de decaimento individuais são somadas elas aumentam o total tanto para as versões de matéria quanto de antimatéria da mesma partícula.

O Dr. Hadley acredita que o efeito de arrastamento de toda a galáxia sobre o tempo-espaço local explica todas essas observações.

Versões de matéria e antimatéria da mesma partícula vão manter exatamente a mesma estrutura, exceto quando elas forem imagens espelhadas umas das outras. Não é sem sentido esperar que o decaimento dessas partículas também comece como uma imagem espelhada exata uma da outra.

No entanto, não é assim que ele termina. O decaimento pode começar como uma imagem espelhada exata, mas o efeito de arrastamento induzido pela rotação da galáxia é significativo o suficiente para fazer com que as diferentes estruturas em cada partícula experimentem diferentes níveis de dilatação do tempo e, portanto, decaiam de formas diferentes.

A variação geral dos diferentes níveis de dilatação do tempo, contudo, fica na média quando cada partícula no decaimento é levada em conta – a violação de CP desaparece e a paridade é conservada.

A beleza desta teoria é que ela também pode ser testada: há previsões que podem ser feitas feitas a partir da teoria e testadas experimentalmente.

A enorme variedade de dados que já existe, que mostram a aparente violação de CP em alguns decaimentos, pode ser re-examinada para ver se há um padrão que está alinhado com a rotação da galáxia.

O artigo do Dr. Hadley somente trata de como o arrastamento do espaço-tempo em escala galáctica poderia explicar as observações experimentais da aparente violação de CP.

Entretanto, a explicação também deixa aberta a porta para aqueles teóricos que acreditam que a violação de CP seria uma ferramenta útil para explicar a separação entre matéria e antimatéria no nascimento do nosso Universo, e o subsequente predomínio aparente da matéria.

De fato, o arrastamento do espaço-tempo em escala galáctica pode até mesmo deixar a porta ainda mais larga: as estruturas primitivas do universo, talvez as mais antigas, podem ter tido massa e giro suficientes para gerar efeitos de arrastamento que poderiam ter tido um efeito significativo na distribuição da matéria e da antimatéria.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=rotacao-galaxia-disparidade-materia-antimateria&id=010130110718&ebol=sim

2011 07 21

Rússia lança radiotelescópio espacial

A Rússia lançou na madrugada de 18/07/2011 o radiotelescópio espacial Spectrum-R, ou Spektr-R, resultado de uma colaboração internacional de mais de 20 países.

O principal objetivo da missão Spektr-R será estudar a estrutura e a dinâmica das fontes de rádio, dentro e fora da Via Láctea.

Os cientistas esperam aprender mais sobre alguns dos problemas fundamentais da astrofísica e da cosmologia, incluindo a estrutura das galáxias, formação das estrelas, buracos negros, matéria escura e sobre o espaço interestelar.

A colocação de um radiotelescópio no espaço permitirá a criação de um gigantesco telescópio virtual, graças à conjunção da antena no espaço com as antenas dos radiotelescópios terrestres.

Devido aos longos comprimentos de onda das ondas de rádio, os refletores dos radiotelescópios devem ser muito grandes para concentrar as ondas em uma boa resolução. Isto é especialmente importante para identificar fontes ocultas, com emissões muito fracas, nas profundezas do Universo.

Uma rede de formada por radiotelescópios baseados no espaço e na terra poderá funcionar como um coletor gigantesco único, maior do que a própria Terra, chegando a uma clareza de sinais sem precedentes.

Essa super rede será formada com a integração do Spektr-R aos telescópios terrestres na Austrália, Chile, China, Europa, Índia, Japão, Coréia, México, Rússia, África do Sul, Ucrânia e EUA.

O Spektr-R possui uma antena principal de 10 metros, capaz de trabalhar em quatro diferentes faixas de ondas de rádio – o radiotelescópio espacial consegue “ouvir” as fontes cósmicas em duas frequências simultaneamente.

O programa inclui cientistas de mais de 20 países. A Rússia forneceu o satélite, a maioria do hardware on-board, a integração do interferômetro e realizou todos os testes pré-lançamento.

O receptor de 92 centímetros foi construído na Índia, o receptor de 18 cm na Austrália, o receptor 1,35 centímetro na Finlândia e o “relógio” de rubídio na Suíça.

Fonte: internet

2011 07 21

Carro elétrico para Fórmula 1 começa a ser discutido

O sucesso do sistema de recuperação de energia KERS está levando os executivos da Fórmula 1 a especularem sobre um carro F1 totalmente elétrico.

“Nós definitivamente teremos um F1 elétrico um dia,” afirmou Nick Fry, chefe da equipe Mercedes e que liderou a equipe Brawn durante a conquista do campeonato mundial da categoria em 2009.

“Para começar, nós vamos introduzi-lo em paralelo com os Fórmula 1 tradicionais, como aconteceu com a versão elétrica das corridas de motocicleta, que ocorrem paralelamente com a categoria TT. No início todo o mundo viu a TT elétrica como uma espécie de piada, mas agora todos a estão levando muito a sério,” afirmou Fry.

O grande catalisador dessa mudança é o sistema KERS: Kinetic Energy Recovery System, sistema de recuperação de energia cinética, que pode funcionar com base em baterias ou em rodas voadoras.

O sistema KERS é formado por um híbrido motor/gerador ligado ao eixo principal do motor e um conjunto de baterias de íons de lítio, instalado junto ao assoalho do carro.

Quando o piloto aciona os freios, o gerador converte a energia cinética em eletricidade para carregar as baterias. Quando precisa de uma energia extra, o mecanismo se inverte e a energia das baterias gira o motor/gerador, dando uma força extra diretamente ao eixo do motor.

Na atual temporada de Fórmula 1, o piloto pode usar o sistema durante 6,6 segundos, o que lhe dá um impulso extra de 60 kilowatts – 80 HPs, para os ainda ligados nos motores a combustão.

Apesar de que algumas falhas nos sistemas KERS já tenham prejudicado alguns pilotos, ele funciona melhor do que os projetistas esperavam.

Como as corridas sempre foram um laboratório para as fábricas, os sistemas de recuperação cinética já chegaram à indústria de carros de rua, nos chamados veículos híbridos. E poderão fazer muito mais pelos carros elétricos.

“Então, imagine [os benefícios de] uma competição de carros projetada inteiramente ao torno de veículos elétricos,” disse Fry.

Os benefícios do KERS já foram além da indústria automobilística: até um pé artificial já utiliza o sistema KERS para auxiliar o movimento das pessoas que recebem a prótese.

Fonte: Internet; http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=carro-formula-1-eletrico&id=010170110718&ebol=sim

2011 07 21

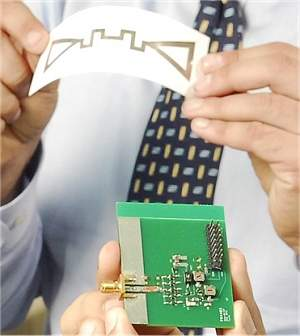

CERN lança iniciativa de hardware aberto

Esta placa de circuito impresso já está disponível no repositório de hardware aberto do Cern: seu lado de baixo traz a inscrição "Licenciado sob a CERN OHL".

Quatro meses após o lançamento da versão alfa, o CERN lançou hoje a versão 1.1 da licença Open Hardware (OHL), destinada a criar um ambiente para o desenvolvimento de equipamentos “abertos”.

O Hardware Aberto pretende fazer pelos equipamentos o que o conceito de Software Livre faz pelos programas de computador.

A licença OHL estabelece um marco legal para facilitar a troca de conhecimento entre a comunidade de design eletrônico.

O CERN, que está patrocinando a iniciativa, é a Organização Europeia para Pesquisa Nuclear, que administra o Grande Colisor de Hádrons, mais conhecido como LHC.

“No espírito da disseminação do conhecimento e da tecnologia, a OHL foi criada para governar o uso, cópia, modificação e distribuição da documentação de projeto de hardware, e a fabricação e distribuição de produtos,” afirma um comunicado do CERN.

A documentação de projeto de hardware inclui diagramas esquemáticos, desenhos, esquemas de circuitos ou placas de circuito impresso, desenhos mecânicos, fluxogramas e textos descritivos, bem como outros materiais explicativos.

“Para nós, o impulso para o hardware aberto foi em grande parte motivado pela inveja bem-intencionada de nossos colegas que desenvolvem os drivers para Linux,” afirmou Javier Serrano, engenheiro do CERN e fundador da organização que vai administrar a licença de hardware aberto.

“Eles são parte de uma comunidade muito grande de designers que compartilham seus conhecimentos e seu tempo para deixar o sistema operacional [Linux] o melhor possível. Sentimos que não havia nenhuma razão intrínseca para que o desenvolvimento de hardware devesse ser diferente,” completou Serrano.

Licença OHL

A licença OHL fornece uma base para a troca de conhecimentos que concilia os princípios do design aberto com a rastreabilidade e com a gestão da propriedade intelectual.

A versão 1.1 incorporou sugestão recebidas da comunidade, a fim de seguir os princípios geralmente aceitos dos movimentos de código livre e código aberto.

O endereço do repositório de hardware aberto é http://www.ohwr.org e da licença OHL é http://www.ohwr.org/cernohl.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=licenca-hardware-aberto&id=020150110708&ebol=sim

2011 07 18

Energia do ar: ondas eletromagnéticas do ambiente viram fonte de energia

Estamos literalmente mergulhados em um mar de ondas eletromagnéticas.

Rádios, TVs, telefones celulares, redes de computador, satélites artificiais e uma infinidade de outros equipamentos emitem essas ondas continuamente.

Agora, um grupo de pesquisadores desenvolveu uma forma de coletar essa energia do ar, transformando-a em eletricidade pronta para ser usada em outros equipamentos.

É mais um elemento da chamada “colheita de energia”, um conceito que vem chamando a atenção dos pesquisadores pela possibilidade de extrair energia do meio ambiente, disponível na forma de luz, vibrações, calor – e ondas de rádio.

Para coletar a energia das ondas eletromagnéticas do ar, a equipe do Dr. Manos Tentzeris, da Universidade da Geórgia, nos Estados Unidos, criou um novo tipo de antena.

As antenas foram fabricadas por uma técnica de impressão por jato de tinta, que aplica tintas condutoras sobre plástico ou papel. Isso permitirá que as antenas sejam construídas junto com o aparelho que deverão alimentar.

Com uma banda ultra-larga, a antena permite captar uma grande variedade de sinais em diferentes faixas de frequência, o que aumenta a capacidade de captação das ondas.

No estágio atual, elas são capazes de captar energia da faixa de frequência das rádios FM até a frequência dos radares – de 100 megahertz (MHz) a 15 gigahertz (GHz).

Na faixa de frequência de TV, os testes mostraram uma capacidade de “colheita” de várias centenas de microwatts – com a antena de colheita de energia posicionada a 500 metros da antena da estação de TV.

As antenas multibanda podem gerar até um miliwatt, o que é suficiente para alimentar circuitos miniaturizados ou sensores sem fios. Ou podem ser usadas para alimentar circuitos menores com mais segurança, uma vez que a antena captará energia de outras faixas de frequência quando uma delas for interrompida ou diminuir de potência.

O processo de captar ondas eletromagnéticas e usá-las para alimentar um circuito não é novo: ele está na base do funcionamento das etiquetas RFID, por exemplo.

Essas chamadas etiquetas inteligentes não possuem baterias: sua antena capta a energia do leitor que está querendo ler seus dados e usa essa energia para “acordar” seu circuito, fazê-lo funcionar e transmitir de volta a informação solicitada.

A ideia do Dr. Tentzeris é fazer isso em maior escala, criando fontes de energia versáteis que possam ser usadas para alimentar qualquer pequeno aparelho, incluindo sensores, microprocessadores e chips de comunicação.

Segundo ele, usando supercapacitores e operação cíclica, será possível, numa próxima etapa, alcançar uma capacidade de geração na casa dos 50 miliwatts.

O dispositivo de colheita de energia poderia ser usado sozinho ou em conjunto com outras tecnologias de geração.

Por exemplo, a energia coletada das ondas eletromagnéticas do ar poderia ajudar um painel solar a carregar uma bateria durante o dia.

À noite, quando as células solares não fornecem energia, a energia coletada continuaria a aumentar a carga da bateria ou impediria sua descarga.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=energia-ar-ondas-eletromagneticas&id=010115110708&ebol=sim

2011 07 18

Descoberto animal com sistema de porca e parafuso biológicos

Os cientistas sempre gostaram de comparar as coisas vivas com as máquinas, das mitocôndrias, chamadas de geradores ou “maquinarias” das células, até o cérebro, visto como um computador ou uma máquina muito sofisticada.

Os cientistas sempre gostaram de comparar as coisas vivas com as máquinas, das mitocôndrias, chamadas de geradores ou “maquinarias” das células, até o cérebro, visto como um computador ou uma máquina muito sofisticada.

Mas nunca havia sido encontrado antes qualquer sinal de um componente tão tipicamente mecânico quanto porcas e parafusos em um ser vivo.

A honra coube ao pouco honroso caruncho.

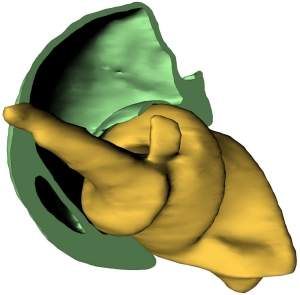

O quadril do Trigonopterus oblongus não consiste das articulações típicas dos seres vivos, mas de um sistema de porca e parafuso biológicos.

A bio-conexão inusitada foi descoberta por cientistas do Instituto Karlsruhe, na Alemanha, usando tomografia computadorizada por radiação síncrotron.

Esta primeira rosca biológica tem de cerca de meio milímetro de diâmetro.

O mais interessante é que, ao contrário dos equipamentos feitos pelo homem, onde parafusos e porcas são usados para fixar componentes, no caruncho o sistema é usado para o movimento.

“Tal construção para o movimento da perna de um animal é absolutamente incomum, com grandes áreas do esqueleto movendo umas por cima das outras. A alimentação da perna ocorre através de uma abertura muito pequena no centro do parafuso,” explica Thomas van de Kamp, coautor da pesquisa.

Na natureza, quadris, ombros, e articulações em geral normalmente são baseados em um sistema de bola-e-soquete, que pode ser operado mais facilmente pelo organismo.

“Agora, descobrimos que a natureza inventou parafusos e porcas antes do homem, porque os carunchos vêm utilizando esta construção há cerca de 100 milhões de anos,” diz Alexander Riedel, coautor do trabalho.

O sistema de porca e parafuso permite que os carunchos baixem suas pernas muito mais do que outros besouros, o que os torna melhores alpinistas.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=animal-articulacao-porca-parafuso-biologicos&id=010170110711&ebol=sim

2011 07 18

A simplicidade de Einstein

Texto:

“Desculpe Sr. Einstein, mas as coisas são mais complicadas”

Redação do Site Inovação Tecnológica – 06/07/2011

Copiado de http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=luz-comprimida-aspectos-particula-onda-luz&id=010115110706&ebol=sim

2011 07 18

A simplicidade de Einstein

Albert Einstein é um dos maiores expoentes da ciência e tido como um dos maiores gênios da humanidade.

Ele ganhou o Prêmio Nobel ao descrever o efeito fotoelétrico, que está na base, por exemplo, do funcionamento de tecnologias como as células solares.

Assim, a premiação maior de um gênio parece ser merecedora da maior reverência possível.

E é. O que não significa que o trabalho seja definitivo.

A ciência trabalha por aproximações sucessivas. Assim, é comum que a descoberta de ontem seja vista como simplista demais pelos cientistas de hoje.

E isso acaba de acontecer com o efeito fotoelétrico de Einstein.

“Nossa experiência mostra que a luz emitida por átomos individuais é muito mais complexa do que a visão simples de Albert Einstein sobre a foto-emissão,” afirmou o Dr. Karim Murr, do Instituto Max Planck de Óptica Quântica, na Alemanha.

E a descoberta veio exatamente de uma área “pouco querida” por Einstein: a mecânica quântica.

Luz: onda e partícula

Na óptica clássica, a luz geralmente é descrita como uma onda. Mas, no nível quântico mais fundamental, essa onda consiste de partículas discretas, chamadas fótons.

Ao longo do tempo, os físicos desenvolveram várias ferramentas para manipular tanto as propriedades de onda quanto as propriedades de partícula da luz.

Por exemplo, eles criaram fontes de fótons individuais, usando átomos únicos, graças à capacidade desses átomos de absorver e emitir fótons um por um – uma luz essencialmente “particulada”.

Murr e seus colegas agora demonstraram que a luz emitida por um único átomo pode apresentar uma dinâmica muito mais rica do que esses domínios de onda e partícula isolados – eles podem interagir e se alterar mutuamente.

Luz comprimida

Interagindo fortemente com a luz dentro de uma cavidade, o átomo modifica as propriedades tipo onda do campo de luz, reduzindo a sua amplitude, ou flutuações de fase, abaixo do nível permitido para a radiação eletromagnética clássica.

Esta é a primeira observação dessa chamada “luz comprimida” – ou luz espremida” – produzida por um único átomo.

A “granularidade” dos fótons em uma onda de luz gera pequenas flutuações da amplitude e da fase da onda.

Nos feixes clássicos, a quantidade mínima de flutuações é a mesma tanto para a amplitude quanto para a fase.

No entanto, criando-se interações entre os fótons, pode-se “comprimir” as flutuações da amplitude abaixo do chamado nível de “ruído de disparo” (shot-noise level) – ou seja, abaixo do limite quântico padrão – à custa de aumentar as flutuações de fase, e vice-versa.

Partícula influencia onda

Na prática, o que os cientistas demonstraram é que as chamadas propriedades de partícula da luz alteram suas propriedades de onda.

As interações fotônicas das mídias ópticas padrão são fracas demais para a observação do fenômeno, exigindo feixes de luz muito brilhantes para serem observadas. Os átomos individuais são candidatos promissores para produzir tais interações em um nível de poucos fótons.

“Normalmente, os objetos quânticos individuais [um átomo, por exemplo] são usados para manipular as propriedades de partícula da luz. É interessante ver que eles também podem modificar as suas propriedades tipo onda, criando luz espremida observável com feixes de excitação contendo apenas dois fótons em média,” disse o Dr. Alexei Ourjoumtsev, coautor da pesquisa.

Da teoria à prática

A capacidade dos átomos individuais para gerar a chamada “luz espremida” foi prevista há 30 anos, mas a quantidade de luz que eles emitem é muito pequena e até agora todas as tentativas de demonstrar experimentalmente essa ideia haviam falhado.

A equipe alemã vem desenvolvendo técnicas sofisticadas ao longo dos últimos anos para resfriar, isolar e manipular átomos individuais, o que lhes permitiu fazer o tão esperado experimento.

E não apenas este. O trabalho da equipe vem rendendo vários frutos ao longo desses anos, tanto no campo da física fundamental quanto nas possibilidades de aplicações tecnológicas futuras.

Europa quer substituir carros por helicópteros pessoais

Estreitando o conceito de "veículo aéreo" a ser utilizado, o objetivo é desenvolver um helicóptero de uso pessoal.

A Europa parece estar levando a sério a ideia de substituir carros por veículos voadores.

O primeiro anúncio oficial veio em 2010, com o lançamento do Projeto PPlane, destinado a elaborar o plano completo para um sistema de transporte aéreo pessoal, com vistas a diminuir os congestionamentos de automóveis nas grandes cidades.

Agora, o principal programa de financiamento de pesquisas europeu acaba de lançar o Projeto myCopter.

Estreitando o conceito de “veículo aéreo” a ser utilizado, o objetivo é desenvolver um helicóptero de uso pessoal.

Os pesquisadores de cinco universidades europeias trabalharão sob a coordenação da Agência Espacial Alemã (DLR), tentando transformar em realidade algo que ainda parece ficção científica: “tornar o transporte de casa para o trabalho tão fácil quanto pegar um elevador.”

“A infraestrutura rodoviária fica totalmente saturada nos horários de pico, e logo não será nem possível nem recomendável construir novas rodovias,” afirma Heinrich Bülthoff, do Instituto Max Planck de Biologia Cibernética, na Alemanha. “A única solução é pensar fora da caixa, e adicionar uma terceira dimensão para a trajetória do viajante.”

“Neste estágio, não estamos ainda projetando a própria aeronave,” explica Felix Schill, da Escola Politécnica Federal de Lausanne, na Suíça. “O que a Europa espera de nós nesta fase inicial é desenvolver tudo o que viabilizará a utilização em larga escala desse tipo de transporte.”

É difícil acreditar que os problemas de um tráfego de helicópteros pessoais não serão até maiores do que os congestionamentos de carros.

Estacionar helicópteros, por exemplo, não parece ser uma manobra mais simples ou que requeira menos espaço do que estacionar um carro.

Leis de trânsito, sistemas de tráfego aéreo e formação de pilotos são outros problemas a serem enfrentados.

“A segurança dos passageiros é obviamente uma das questões mais sensíveis,” continua Schill. “Teremos que projetar sistemas extremamente seguros para evitar colisões.”

Mas os cientistas estão entusiasmados e já pensando realmente “fora da caixa”.

As ideias vão desde as “aerovias” expressas até o voo em formação, em que os helicópteros voariam de forma automatizada na maior parte do tempo, e o uso de mini-radares, como os que estão sendo desenvolvidos para evitar a colisão de automóveis.

No quesito técnico, os pesquisadores estimam que um helicóptero elétrico com contra-rotores poderá cobrir até 20 quilômetros usando apenas suas baterias – mais do que a distância média de casa para o emprego da maioria dos trabalhadores.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=substituir-carros-helicopteros-pessoais&id=010170110705&ebol=sim

2011 07 18

Atlantis chega à Estação Espacial Internacional pela última vez

O Atlantis, último ônibus especial americano, chegou até a Estação Internacional Espacial, onde realiza sua missão final.

Lançado na última sexta-feira, a nave leva suprimentos essenciais para os tripulantes da estação, incluindo mais de uma tonelada de comida, suficiente para um ano.

Os astronautas do Atlantis ficarão na Estação Espacial Internacional até a próxima semana, quando a nave fará sua última jornada para a Terra.

A viagem do Atlantis marca o fim do programa de ônibus espaciais da Nasa, agência espacial americana, que durou 30 anos.

O programa foi considerado caro demais pelo governo dos Estados Unidos.

Quando o Atlantis retornar de sua jornada final, o ônibus espacial se tornará uma peça de museu, no Centro Espacial Kennedy, na Flórida. Os ônibus espaciais restantes, Enterprise, Discovery e Endeavour, serão enviados para outros museus nos Estados Unidos.

O primeiro ônibus espacial, o Columbia, foi lançado em 12 de abril de 1981.

Fonte: Internet

2011 07 18

Papel solar: células solares são impressas em papel

Fabricar células solares diretamente em papel ou tecido, de um modo simples e rápido.

Este é o objetivo de pesquisadores do Instituto de Tecnologia de Massachusetts (MIT), nos Estados Unidos.

Eles já construíram diversos protótipos funcionais, com alguns mantendo o funcionamento depois de diversos meses e muitas dobraduras.

Há uma forte tendência no sentido de trazer os circuitos eletrônicos para mais próximo ao que as pessoas usam no dia-a-dia, o que inclui sobretudo papel e e tecido das roupas, mas também plásticos, sobretudo folhas flexíveis, que possam ser enroladas e dobradas.

Antenas capazes de capturar a energia do ar e até uma caneta capaz de desenhar circuitos eletrônicos foram demonstrados nos últimos dias. Células solares impressas por jato de tinta também já foram demonstradas experimentalmente por diversos grupos.

Tudo isto está sendo possível graças ao desenvolvimento das chamadas tintas eletrônicas, que não são exatamente tintas, mas soluções de partículas capazes de desempenhar a função desejada.

O trabalho do MIT é um pouco mais complexo do que a impressão jato de tinta ou laser, mas também está dando resultados mais robustos.

O processo de impressão usa vapor – e não líquidos ou pó – em um processo que ocorre em temperaturas abaixo de 120 ºC – uma temperatura bastante amena em comparação com a fabricação de uma célula solar fotovoltaica tradicional, que emprega temperaturas elevadas e elementos corrosivos.

Nessas condições mais amenas, é possível empregar materiais como papéis não tratados, tecidos ou plástico como substratos para imprimir as células.

São aplicadas cinco camadas de materiais, que são depositados sobre o papel em etapas sucessivas. Uma máscara, também feita de papel, é usada para formar os padrões das células solares.

O processo ainda exige uma câmara a vácuo, para evitar a contaminação por poeira ou outras impurezas, o que diminuiria o rendimento das células solares.

Terminada a “impressão”, basta ligar os eletrodos e colocar o “papel fotoelétrico” sob a luz para que ele comece a gerar energia.

Em uma das demonstrações, um avião de papel foi construído com a folha fotoelétrica e começou a gerar energia tão logo acabou de ser dobrado. Em outra, as células solares foram impressas sobre uma fina folha de plástico PET, que foi dobrada e desdobrada mil vezes, sem perder a funcionalidade.

O rendimento das células solares impressas ainda é baixo – em torno de 1% – mas suficiente para alimentar pequenos aparelhos portáteis e sensores ambientais. Os pesquisadores afirmam que estão trabalhando nesse quesito, ajustando os materiais aplicados na técnica de deposição por vapor para melhoria da eficiência.

“Nós demonstramos a robustez dessa tecnologia. Acreditamos que poderemos fabricar células solares em larga escala capazes de atingir desempenhos recordes em termos de watts por quilo [de material],” disse Vladimir Bulovic, um dos autores da pesquisa.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=papel-solar-celulas-solares-impressas-papel&id=010115110713&ebol=sim

2011 07 18

Sinapse artificial memoriza e esquece como o cérebro

Um grupo de pesquisadores japoneses desenvolveu um circuito eletrônico que imita o sistema de memorização e esquecimento que caracteriza o aprendizado do cérebro humano.

O “circuito sináptico” – um dispositivo totalmente de hardware – reproduz de forma totalmente autônoma dois fenômenos que são marcas registradas da atividade neural do cérebro: a memorização das informações necessárias e o esquecimento das informações desnecessárias.

Acredita-se que a memória seja o resultado de dois tipos de plasticidade sináptica: a plasticidade de curto prazo e a potenciação de longo prazo. Só os registros mais importantes – e, portanto, mais fortes ou mais intensos – passariam ao registro definitivo.

Os cientistas tentam há anos reproduzir esse comportamento neural do aprendizado, dentro do campo conhecido como engenharia neuromórfica.

Isso vem sendo tentado principalmente por meio de software, o que não é uma tarefa fácil devido à complexidade das interconexões verificadas nos processos neurais que dão sustentação ao pensamento.

Mas Takeo Ohno e seus colegas do Instituto Nacional de Ciência dos Materiais, no Japão, decidiram adotar uma abordagem de hardware.

A chave atômica tem sua condutância reforçada pela intensidade dos estímulos. Um ou poucos estímulos geram uma memória de curto prazo (STP). O reforço dos estímulos leva a uma memória de longo prazo (LTP).

O circuito sináptico é essencialmente uma chave atômica de lacuna – onde a lacuna se refere a uma minúscula distância entre dois eletrodos -, que funciona como um memristor.

O componente é formado por um eletrodo de prata, recoberto com sulfeto de prata (Ag2S), e um contra-eletrodo de platina, com uma separação de um nanômetro entre eles – portanto, um componente totalmente inorgânico.

Seu funcionamento se dá pela formação e destruição de uma “ponte”, formada por um átomo de prata, que se coloca entre os dois eletrodos. A ponte é construída e destruída controlando-se a reação eletroquímica (uma reação de estado sólido) do condutor híbrido iônico/eletrônico, ou eletroiônico, o sulfeto de prata.

A chave atômica tem dois estados de condutância: o primeiro é produzido por um sinal fraco, o que faz com que esse estado se degrade rapidamente; o outro é gerado por um sinal mais forte, o que exige um outro sinal igualmente forte que o anule.

Usando o movimento dos íons, os pesquisadores conseguem controlar essa ponte metálica entre os eletrodos.

Isso porque o movimento dos íons depende da frequência de entrada do estímulo elétrico – que representa o “aprendizado”. Em outras palavras, eles conseguem controlar a intensidade da conexão sináptica do seu circuito neural artificial.

Na prática, o circuito sináptico ajusta sua própria “força” (ou intensidade) de acordo com a frequência da estimulação elétrica – o estímulo intermitente causa um decaimento espontâneo do nível de condutância da sinapse inorgânica quando ela opera em níveis críticos de tensão.

No circuito, essa frequência do estímulo nada mais é do que a frequência de uma corrente elétrica.

Contudo, vista sob o ponto de vista de um emulador de um circuito neural, essa frequência representa a quantidade de vezes que o “cérebro artificial” esteve exposto a um aprendizado em particular.

Ou seja, quando maior a frequência, maior será a fixação do material “aprendido”.

No experimento, os pesquisadores construíram uma matriz de 7 x 7 pontos – pense neles como os pixels de uma tela – cada um contendo sua própria sinapse artificial.

Os valores inseridos poucas vezes – com baixa frequência – somem rapidamente da tela. O circuito sináptico se “esquece” deles porque, não sendo repetidos uma quantidade de vezes suficiente, eles não devem ser importantes.

Mas aqueles que são repetidos várias vezes logo permanecem gravados, imitando o aprendizado por repetição – o que os pesquisadores chamam de “lembrar-se do que é importante”.

Ao contrário da sinapse sintética construída com nanotubos de carbono, esta emula a memorização em um dispositivo de hardware único e muito simples, e sem a necessidade de qualquer programação externa.

Além disso, outros experimentos têm resultado em sinapses artificiais que só funcionam para o fim específico para a qual foram projetadas – ao contrário da flexibilidade do “aprendizado” demonstrado agora.

Como o novo circuito sináptico permite a realização de diversas operações sem qualquer programação prévia, os cientistas acreditam que ele é um passo importante para a construção de sistemas de inteligência artificial capazes de aprender com o uso, de forma similar aos humanos.

“Os elementos sinápticos inorgânicos são funcionalmente adequados para o projeto de sistemas neurais que possam funcionar sem a necessidade dos softwares de difícil escalabilidade e da pré-programação atualmente empregada nos sistemas de redes neurais, com claro potencial para [a construção de um] hardware apropriado para os sistemas inteligentes físicos e artificiais,” escrevem os pesquisadores.

Mas computadores que repliquem de fato o cérebro ainda dependerão de progressos futuros.

Por exemplo, embora o comportamento de memristor da chave atômica tenha ele próprio uma memória, “lembrando-se” da última corrente que o atravessou, os pesquisadores não conseguiram demonstrar uma correlação entre o tempo e a memória registrada no dispositivo.

Ou seja, várias entradas iguais ao longo do tempo não reforçam o “aprendizado”, o que é uma característica da neuroplasticidade.

Esses computadores inspirados em cérebros biológicos são vistos como uma das saídas para superar o atual paradigma da computação baseada em transistores eletrônicos.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=sinapse-artificial&id=010810110714&ebol=sim

2011 07 18