Arquivo

Quer saber mais? – Dispositivos de iniciação do BIOS

Um dispositivo de iniciação é qualquer dispositivo que deve ser iniciado antes da carga do sistema operacional.

Isto inclui os dispositivos de entrada como o teclado e dispositivos de saída como o Monitor, os dispositivos de armazenamento como drive de disquete, disco rígido, CD-ROM, etc.

Aqui temos em especial os dispositivo que podem carregar o sistema operacional (em antigas máquinas PC, o drive de disquete e o disco rígido).

Em uma BIOS moderna, o usuário pode selecionar vários dispositivos para fazer a iniciação, por exemplo disquete, Superdisk, Disco Rígido, SCSI, Cdrom, Zip drive, ou USB (USB-FDD, USB-ZIP, USB-CDROM, USB-HDD).

Podemos instalar o Windows, como exemplo, no primeiro disco rígido e o Linux no segundo, alterando apenas os parâmetros da BIOS, podemos modificar qual sistema operacional a carregar a qualquer tempo.

Ainda, ao iniciar o processo de iniciação, a CPU do computador executa a instrução localizada no registrador de memória FFFFFFFF0h do BIOS.

Este registrador de memória corresponde a última posição de memória da BIOS.

Ele contém uma instrução que faz com que a execução seja desviada para o local no BIOS onde começa o programa inicial.

Este programa executa um auto-teste (POST), que é um teste para verificar o funcionamento de diversos dispositivos no computador.

O BIOS busca em uma lista de dispositivos pré-configurados até encontrar um que pode ser o dispositivo de iniciação. Se não encontra este dispositivo, um erro é apresentado e o processo de iniciação termina.

Se o dispositivo de iniciação é encontrado, o BIOS carrega e executa o MBR (Registro mestre de iniciação). Em muitos casos, o MBR verifica a tabela de partições em busca de uma partição ativa. Se uma partição ativa é encontrada, o MBR carrega e executa o setor de iniciação da partição. O setor de iniciação é específico do sistema operacional, entretanto em muitos sistemas sua principal função é carregar e executar o núcleo (Kernel).

2011 11 29

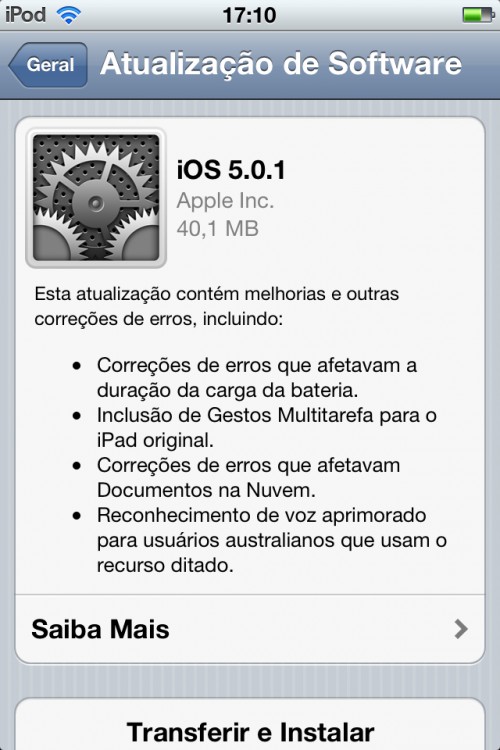

Lançado iOS 5.0.1, corrigindo aquele problema de duração da bateria

A Apple liberou ao público geral o iOS 5.0.1, atualização que corrige vários problemas no sistema e traz algumas melhorias.

Entre os problemas corrigidos estão alguns que faziam o sistema gastar mais energia, resultando em um menor tempo de duração da bateria quando comparado ao iOS 4.x no mesmo dispositivo.

A atualização ainda traz gestos multitarefa para o iPad original (a primeira versão), correções de erros no Documentos na Nuvem, e melhorias no reconhecimento de voz para usuários australianos.

Uma grande novidade no iOS 5 em si foi a forma como o sistema lida com as atualizações e com o computador.

O iOS 5 é independente de PC/Mac, podendo ser comandado pelo próprio aparelho.

A configuração inicial ao ligar um produto pela primeira vez não depende mais de um computador e, de fato, é possível manter um iPhone, iPad ou iPod touch sem precisar conectá-lo em nenhum momento a um PC ou Mac.

Como resultado as atualizações também podem ser entregues via OTA (over the air), direto no aparelho.

Quem atualiza pelo iTunes precisa baixar toda a imagem do sistema, um arquivo gigantesco com várias centenas de MB. Mas quem for atualizar pelo próprio aparelho precisará pegar apenas um arquivo com cerca de 40 MB, dependendo do produto.

Voyager muda de motores para durar mais 10 anos

A sonda espacial Voyager 2 recebeu e obedeceu à ordem para passar a operar com seu conjunto de propulsores de backup.

As sondas Voyager 1 e Voyager 2 são equipadas com seis pares de propulsores – três primários e três de backup – para controlar seus movimentos e seu posicionamento nos eixos X, Y e Z.

A mudança permitirá que a sonda de 34 anos de idade reduza a quantidade de energia que consome, até agora gasta para manter operacionais os propulsores anteriormente não utilizados.

A mudança permitirá o desligamento do aquecedor que mantém quente o duto de combustível para o propulsor primário.

Isto vai poupar cerca de 12 watts de potência. A “usina atômica” em miniatura que abastece a sonda atualmente produz cerca de 270 watts de eletricidade.

A redução no consumo de energia vai permitir que a sonda continue a operar por mais uma década, mesmo como a queda contínua de potência de seu reator, conforme sua fonte de radioisótopos vai se exaurindo.

O comando foi enviado no último dia 4 de Novembro. A confirmação do comando e de seu resultado chegou nesta segunda-feira, dia 15.

A Voyager 2 está hoje a cerca de 14 bilhões de quilômetros da Terra, em uma região conhecida como heliosheath, a camada mais externa da heliosfera, onde o vento solar, que flui vindo do Sol, é freado pela pressão do gás interestelar.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=vovo-yager-muda-motores-durar-mais-10-anos&id=010130111115&ebol=sim

2011 11 21

NASA desenvolve material super-negro

Uma seção da cobertura do material foi retirada para que se possa visualizar o alinhamento vertical dos nanotubos de carbono. A cor cinza é falsa - caso contrário, tudo o que se veria seria um belo retângulo escuro. - http://www.inovacaotecnologica.com.br/noticias/imagens/010160111109-nasa-multibanda.jpg

Engenheiros da NASA criaram um novo material capaz de absorver mais de 99% da luz que o atinge.

Embora já existam materiais artificiais capazes de absorver até 99,9% da luz visível, este novo material absorve não apenas a luz visível, mas também a ultravioleta, a infravermelha e a infravermelha distante.

O material é resultado da deposição de nanotubos de carbono sobre uma pastilha de silício.

Quando a luz atinge o material, ela é aprisionada pelos pequenos nanotubos. Usando nanotubos de paredes múltiplas – com várias camadas de carbono – os cientistas conseguiram que vários comprimentos de onda fossem aprisionados.

“Os testes de reflectância mostraram que nossa equipe aumentou em 50 vezes a capacidade de absorção do material,” disse John Hagopian, coordenador do grupo.

Os testes também revelaram que o novo material super absorvente terá grande utilidade em aplicações espaciais, sobretudo nos sensores de telescópios que precisem observar a luz vinda do espaço em vários comprimentos de onda.

Ele poderá ser usado, por exemplo, para eliminar brilhos indesejados, capturando a luz de fundo para evitar que ela reflita e interfira com a luz que os cientistas estejam tentando medir.

Esta alta capacidade de absorção permitirá a observação de objetos tão distantes no universo que os astrônomos não conseguem vê-los em luz visível, ou aqueles em áreas de alto contraste, incluindo planetas orbitando outras estrelas.

Hagopian afirma que haverá usos também aqui na Terra, em estudos sobre os oceanos ou a atmosfera. Mais de 90% da luz que chega aos instrumentos de monitoramento ambiental vem da atmosfera, poluindo o fraco sinal em que os cientistas estão interessados.

Como o material não reflete virtualmente nenhuma luz, ele parece totalmente escuro não apenas aos olhos humanos, mas também a vários sensores usados em astronomia e em outras aplicações.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=nasa-material-super-negro&id=010160111109&ebol=sim

2011 11 21

Experimento obtém novos resultados sobre propriedades de neutrinos

Observação de um neutrino batendo em um próton em uma câmara de bolhas. A colisão ocorreu no ponto onde emanam três faixas da direita da fotografia.

O neutrino é uma partícula subatômica sem carga elétrica e que interage com outras partículas apenas por meio da interação gravitacional e da força nuclear fraca.

É conhecido por suas características extremas: é extremamente leve (algumas centenas de vezes mais leve que o elétron), existe com enorme abundância (é a segunda partícula mais abundante do Universo conhecido, depois do fóton) e interage com a matéria de forma extremamente débil (cerca de 65 bilhões de neutrinos atravessam cada centímetro quadrado da superfície da Terra voltada para o Sol a cada segundo.

Agora, cientistas do experimento Double Chooz, com importante participação de físicos brasileiros, detectaram o desaparecimento de antineutrinos do elétron a curta distância.

Este resultado ajuda a determinar o até então desconhecido terceiro ângulo de mistura dos neutrinos, uma propriedade fundamental com consequências importantes para a física de partículas e astropartículas.

A colaboração Double Chooz estuda neutrinos capturados em um detector instalado próximo aos dois reatores da usina nuclear próxima à cidade de Chooz, na França.

A medida deste terceiro ângulo completa o quadro de oscilações de neutrinos, como descrito por outros experimentos, e abre novas perspectivas para entender porque só encontramos matéria e nenhuma antimatéria no nosso Universo atual.

A colaboração Double Chooz estuda neutrinos capturados em um detector instalado próximo aos dois reatores da usina nuclear próxima à cidade de Chooz, na França - http://www.inovacaotecnologica.com.br/noticias/imagens/010130111118-double-chooz.jpg

Neutrinos são as partículas mais comuns existentes no Universo, mas são as menos visíveis.

Eles ficaram famosos recentemente, quando cientistas acreditam ter observado neutrinos viajando mais rápido do que a luz.

Eles existem em três tipos, chamados de “sabores”, e são conhecidos desde o final dos anos 90 por sua capacidade especial de mudar de um tipo para outro. Este fenômeno é chamado de oscilação de neutrinos e implica que os neutrinos têm massa.

Oscilações de neutrinos são atualmente um campo de pesquisa muito ativo, com vários experimentos buscando uma descrição completa do mecanismo.

Neutrinos são produzidos de várias formas, como por processos de fusão no interior do Sol e pelos raios cósmicos que bombardeiam a atmosfera.

Os três diferentes sabores de neutrinos estão relacionados com os léptons carregados que são seus parceiros: elétron, múon e tau.

O experimento Double Chooz – que integra universidades e institutos de pesquisa do Brasil, Inglaterra, França, Alemanha, Japão, Rússia, Espanha e EUA – se dedica a medir oscilações de neutrinos com precisão sem precedentes, ao observar antineutrinos produzidos num reator nuclear próximo.

Esse experimento começou a coletar dados há seis meses. Na conferência LowNu 2011, na Coréia do Sul, na semana passada, a colaboração anunciou seus primeiros resultados, relatando novos dados consistentes com oscilações de curto alcance. Este resultado é baseado na observação do “desaparecimento” de antineutrinos no fluxo esperado produzido pelo reator nuclear.

Apesar de esta ser a interpretação corrente, alguns cientistas acreditam que não exista um antineutrino, mas que os neutrinos são suas próprias antipartículas, e estão tentando provar isto em um experimento chamado EXO (Enriched Xenon Observatory), nos Estados Unidos.

As oscilações do neutrino dependem de três parâmetros de mistura, dos quais dois são grandes e foram medidos anteriormente.

O terceiro ângulo de mistura chamado θ13 (lê-se “teta um três”) não tinha sido bem medido até agora e só havia um limite superior para seu valor. A colaboração Double Chooz, observando o “desaparecimento” de antineutrinos do elétron, apresenta evidência para oscilações envolvendo o terceiro ângulo com o seguinte valor: sin2 (2θ 13)= 0,085 ± 0,051. A probabilidade de não haver oscilação dada pelos resultados preliminares é apenas 7,9%.

A medida do último ângulo de mistura “θ 13” (teta13) é crucial para futuros experimentos destinados a medir a diferença entre oscilações de neutrinos e antineutrinos (violação de CP no setor leptônico). Além disso, este ângulo está relacionado indiretamente com a origem da assimetria entre matéria e antimatéria no Universo.

“O terceiro ângulo de mistura é atualmente o elo perdido da física de neutrinos. Medi-lo com precisão é a chave para abrir a porta para uma nova física, além do modelo padrão da física de partículas, e agora estamos muito perto disso”, disse Herve de Kerret, pesquisador do CNRS da França e porta-voz da colaboração Double Chooz.

Em junho de 2011, foram relatados por experimentos de aceleradores os primeiros sinais de oscilação de neutrinos do múon para neutrinos do elétron, envolvendo este terceiro ângulo.

A colaboração Double Chooz, que utilizou um detector localizado a uma distância de cerca de 1.000 m dos núcleos dos reatores, ao observar o “desaparecimento” de antineutrinos do elétron, apresenta evidências complementares e importantes de oscilação também envolvendo o terceiro ângulo de mistura.

A precisão da medida vai aumentar ainda mais ao longo do tempo e após o início da operação, no final de 2012, de um segundo detector localizado a uma distância de 400 m do primeiro. Nessa última distância, nenhuma transformação significativa em outro tipo de neutrino é esperada. Mas, combinando os resultados dos dois detectores, o valor de sin2 (2θ 13) poderá ser determinado com precisão ainda maior.

O alvo do detector é composto de 10 m3 de cintilador líquido desenvolvido especificamente para este experimento. O cintilador é dopado com gadolínio, a fim de marcar os nêutrons provenientes do decaimento beta inverso induzido pelos antineutrinos do reator.

O alvo está cercado por camadas de outros líquidos que o protegem contra outras partículas e radioatividade do meio ambiente. O alvo é visto por 390 fotomultiplicadoras imersas no líquido cintilador, que convertem as interações em sinais eletrônicos.

Estes sinais são processados em um sistema de aquisição de dados, que está pronto para coletar dados ao longo dos próximos cinco anos.

A contribuição brasileira ao experimento Double Chooz envolve atualmente sete pesquisadores: João dos Anjos (coordenador), Ademarlaudo Barbosa, Herman Pessoa Lima Jr, Iuri Pepe e Gustavo Valdiviesso (todos do Centro Brasileiro de Pesquisas Físicas – CBPF), Ernesto Kemp (UNICAMP) e Pietro Chimenti (UFABC).

A colaboração brasileira consistiu no desenvolvimento e construção de uma eletrônica capaz de medir a energia dos múons cósmicos que cruzam o detector.

Isto possibilitará identificar e rotular múons altamente energéticos e candidatos a produzir nêutrons por espalação, uma das fontes mais importantes de ruído para eventos de neutrinos. A eliminação desse ruído permitirá reduzir os erros sistemáticos na medida de teta13.

A eletrônica foi projetada no CBPF e os módulos para o detector mais distante estão sendo construídos em cooperação com indústrias brasileiras e serão adicionados ao detector central em março de 2012 por ocasião de uma parada para manutenção.

Fonte: Internet, http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=propriedades-neutrinos&id=010130111118&ebol=sim

2011 11 21

Processador analógico imita o cérebro

A corrente elétrica flui ao longo dos transistores de forma semelhante ao movimento dos íons ao longo dos canais iônicos em uma célula - ou seja, este é um processador analógico. - http://www.inovacaotecnologica.com.br/noticias/imagens/010810111117-chip-neural-mit.jpg

Pesquisadores criaram um processador inteiramente eletrônico que imita o funcionamento das sinapses cerebrais.

Como o cérebro não é digital, como os processadores eletrônicos, os cientistas decidiram criar um processador analógico.

Usando cerca de 400 transistores, o chip neuromórfico imita como os neurônios cerebrais se adaptam em resposta a novas informações – um fenômeno conhecido como plasticidade cerebral.

A corrente elétrica flui ao longo dos transistores de forma semelhante ao movimento dos íons ao longo dos canais iônicos em uma célula.

Ou seja, o chip não é digital, ele é analógico, como o cérebro humano.

Os pesquisadores construíram os transistores para que eles imitassem a atividade dos diferentes canais iônicos presentes nas ligações entre os neurônios.

“Nós podemos ajustar os parâmetros do circuito para replicar canais iônicos específicos,” explicou Poon. “Nós agora temos um mecanismo para capturar qualquer um dos processos iônicos que ocorrem em um neurônio.”

O novo processador neuromórfico não imita unicamente os disparos dos neurônios, ele reproduz as condições de geração dos potenciais de ação que levam ao disparo dos neurônios.

“Se você quer realmente imitar o cérebro de forma realística, você tem que fazer mais do que disparar os neurônios. Você precisa capturar os processos intracelulares, que são baseados em canais iônicos,” explica Poon.

Dean Buonomano, professor de neurobiologia da Universidade da Califórnia, não envolvido diretamente com a pesquisa, afirmou que “o nível de realismo biológico [do chip] é impressionante”.

O novo chip representa “um avanço significativo nos esforços para incorporar o que nós sabemos sobre a biologia dos neurônios e da plasticidade sináptica em processadores CMOS,” completou ele.

De fato, se ainda está longe dos equipamentos de consumo, o processador neural analógico pode se tornar imediatamente uma ferramenta importante para aumentar justamente estes conhecimentos sobre o cérebro.

Mesmo os supercomputadores precisam de horas para simular funções neurais específicas, como o sistema de processamento visual humano.

Já o processador neuromórfico analógico é mais rápido do que o próprio sistema biológico, o que permitirá acelerar muito esses estudos.

Outra aplicação potencial do novo chip é na construção de interfaces entre equipamentos eletrônicos e sistemas biológicos, por exemplo, estabelecendo canais de comunicação direta entre o cérebro e equipamentos robotizados, como as próteses.

Os 400 transistores imitam o funcionamento de uma única sinapse.

Se parece pouco, basta ver que um processador estado-da-arte tem cerca de 700 milhões de transistores – o que abriria a possibilidade teórica da emulação de de quase dois milhões de sinapses em um único chip. Mas este é um futuro distante.

Com o advento da computação orgânica, as pesquisas rumo a um processador neural mostram sinais de convergência.

Mas ainda é difícil afirmar se serão os processadores moleculares que evoluirão rumo aos seus equivalentes eletrônicos, ou se serão estes que irão incorporar mecanismos que imitem o cérebro, criando o chamado processador neuromórfico.

O trabalho agora apresentado pelo Dr. Poon e seus colegas do MIT enquadra-se nesta segunda categoria, similar aos processadores cognitivos da IBM.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=processador-analogico-imita-cerebro&id=010810111117&ebol=sim

2011 11 21

Co-processador de 1 teraflops da Intel

O chip não é um processador comum, é um coprocessador, cuja função é tirar do processador a incumbência de realizar os cálculos matemáticos mais intensivos. - http://www.inovacaotecnologica.com.br/noticias/imagens/010150111118-knights-corner.jpg

A Intel apresentou o seu Knights Corner, um co-processador que permite alcançar a marca de 1 teraflops – 1 trilhão de operações de ponto flutuante por segundo.

O chip não é um processador comum, é um co-processador, cuja função é tirar do processador a incumbência de realizar os cálculos matemáticos mais intensivos.

No início do desenvolvimento dos computadores pessoais, os chamados co-processadores matemáticos eram comuns.

Com o passar do tempo, sobretudo graças à miniaturização, eles foram levados para dentro do processador.

Agora, com os problemas crescentes de dissipação de calor, a empresa parece ter encontrado na reinvenção do co-processador separado uma forma de aumentar a velocidade dos computadores sem risco de fritar os chips.

O mais importante, contudo, parece ser fazer frente às GPUs, os processadores gráficos da nVidia, que estão dominando o mercado dos chamados “supercomputadores de baixo custo”.

O Knights Corner tem nada menos do que 50 núcleos em um único chip e, segundo a empresa, já incorpora a especificação PCI Express 3.0, que eleva a transferência de dados para 32 gigabytes por segundo.

Quando a Intel apresentou seu primeiro supercomputador na classe de 1 teraflops, em 1997, a máquina usava 10.000 processadores Pentium II, o estado-da-arte na época, e custava US$55 milhões.

Agora tudo caberá em um único conjunto processador/co-processador.

Em 2008, o Roadrunner, da IBM, foi o primeiro supercomputador a atingir a marca de 1 petaflops – 1.000 trilhões de operações por segundo.

A Intel afirma que espera chegar aos exaflops em 2018. Já a IBM não marcou data, mas afirma que seus computadores de classe exaflops usarão processadores com comunicação por luz.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=intel-apresenta-co-processador-1-teraflops&id=010150111118&ebol=sim

2011 11 21

Luz é gerada pelo vácuo

Os fótons virtuais que pululam do vácuo quântico são capturados em duplas por um "espelho" que vibra a uma velocidade próxima à velocidade da luz. - http://www.inovacaotecnologica.com.br/noticias/imagens/010115111118-luz-do-vacuo.jpg

Cientistas conseguiram transformar escuridão em luz: eles produziram luz a partir do vácuo.

A realização do experimento, previsto há mais de 40 anos, coube a Christopher Wilson e seus colegas da Universidade Chalmers, na Suécia.

O grupo conseguiu capturar fótons que pululam do vácuo quântico, aparecendo e desaparecendo continuamente.

O experimento é baseado em um dos mais estranhos, mas mais importantes, princípios da mecânica quântica: o princípio de que o vácuo pode ser tudo, menos um vazio “repleto de nada”.

Na verdade, o vácuo está repleto de partículas que estão flutuando continuamente entre a existência e a inexistência: elas surgem do nada – ou melhor, do vácuo quântico – têm uma vida efêmera e desaparecem novamente.

Seu tempo de vida é tão curto que esses fótons são mais comumente conhecidos como partículas virtuais.

O que os pesquisadores fizeram foi pescar alguns desses fótons e dar-lhes a eternidade em termos quânticos, ou seja, transformá-los em fótons reais, luz que pode ser detectada por um sensor e medida.

Para capturar os fótons virtuais, os pesquisadores simularam um espelho movendo-se a uma fração significativa da velocidade da luz. O fenômeno, conhecido como efeito de Casimir dinâmico, foi observado experimentalmente pela primeira vez.

“Como não é possível fazer um espelho mover-se rápido o suficiente, nós desenvolvemos outra técnica para obter o mesmo efeito,” explica o professor Per Delsing, coordenador da equipe. “Em vez de variar a distância física até um espelho, nós variamos a distância elétrica de um circuito elétrico que funciona como um espelho para micro-ondas”.

O “espelho” consiste em um sensor quântico conhecido como SQUID (Superconducting Quantum Interference Device), que é extremamente sensível a campos magnéticos.

Alterando a direção do campo magnético vários bilhões de vezes por segundo, os cientistas fizeram o “espelho” vibrar a uma velocidade equivalente a 25% a velocidade da luz.

Isto é cinco vezes mais do que a tentativa anterior, quando os cientistas afirmaram pela primeira vez ter produzido luz a partir do nada – aquele artigo, contudo, ainda não havia sido aceito para publicação em uma revista científica, o que significa que outros cientistas não haviam avaliado o experimento.

“O resultado foi que os fótons apareceram em pares do vácuo, e nós pudemos medi-los na forma de radiação de micro-ondas,” disse Delsing, ou seja, exatamente como a teoria previa.

O que acontece durante o experimento é que o “espelho” transfere uma parte de sua energia cinética para os fótons virtuais, o que os ajuda a se “materializarem”.

Segundo a mecânica quântica, vários tipos de partículas pululam no vácuo quântico. Os cientistas acreditam que foram capazes de detectar os fótons porque eles não têm massa.

“É necessário relativamente pouca energia para excitá-los e tirá-los do estado virtual. Em princípio, pode-se criar outras partículas do vácuo, como elétrons e prótons, mas isso vai exigir um bocado mais de energia,” disse Delsing.

Agora os cientistas querem estudar em detalhes esses fótons emergentes: como eles surgem aos pares, os cientistas acreditam que eles possam ser úteis para o desenvolvimento de computadores quânticos, com seus qubits de partículas entrelaçadas.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=vacuo-produz-luz&id=010115111118&ebol=sim

2011 11 21

RRAM: criada memória flexível totalmente funcional

Cada célula da memória RAM flexível é formada por dois componentes inovadores: um memristor e um transístor de cristal único.

Engenheiros coreanos criaram a primeira memória RAM flexível totalmente funcional.

Eles a chamam de RRAM ou, mais formalmente, de memória de acesso aleatório resistiva não-volátil flexível.

Keon Jae Lee e seus colegas do Instituto KAIST afirmam que as células de RRAM podem ser acessadas aleatoriamente, escritas e apagadas, em condições normais de operação, tudo sobre um substrato plástico flexível.

Este é um feito importante da eletrônica orgânica, cuja principal promessa – além do baixo consumo de energia e baixo custo – é a criação de equipamentos flexíveis, como telas de enrolar e computadores de vestir.

Embora vários grupos de pesquisa tenham apresentado memórias fabricadas sobre plástico antes, as interferências entre as células têm impedido que elas cheguem à fase de produção industrial.

A grande dificuldade é a integração dos transistores com as células de memória, uma vez que os transistores orgânicos ainda não haviam alcançado um desempenho suficiente para controlar as células de memória convencionais.

A equipe do Dr. Lee resolveu o problema da interferência entre as células de memória usando dois componentes individualmente inovadores.

O primeiro é um memristor, um componente inovador que está sendo considerado a base de uma nova geração de computadores graças à sua capacidade de “lembrar” dos dados que ele registra – por isso ele é muitas vezes chamado de sinapse artificial.

Cada memristor, feito de óxido de titânio, foi integrado ao segundo componente inovador, um transístor formado por um único cristal de silício.

E, não menos inovador, ambos foram postos para funcionar sobre um substrato plástico, em vez da tradicional pastilha de silício.

“Este resultado representa uma tecnologia com um fortíssimo potencial para tornar realidade sistemas eletrônicos verdadeiramente flexíveis, para o desenvolvimento de computadores dobráveis, em um futuro próximo,” disse o pesquisador.

Fonte: http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=rram-memoria-flexivel&id=010110111104&ebol=sim

2011 11 18

Laser spintrônico ilumina caminho das telecomunicações

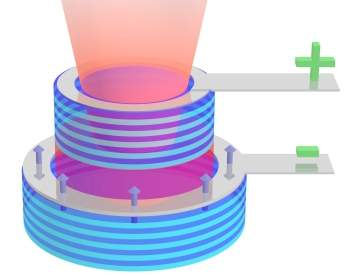

A injeção de elétrons polarizados pelo spin em microlasers semicondutores torna-se possível alcançar velocidades de modulação muito superiores aos dos lasers convencionais.

Cientistas da Universidade de Ruhr-Bochum, na Alemanha, anunciaram o desenvolvimento de um novo tipo de raio laser semicondutor ultra-rápido.

O chamado “laser de spin” – ou laser spintrônico – usa o momento angular dos elétrons – o chamado spin – para quebrar a barreira de velocidade dos lasers convencionais.

O novo laser de spin tem o potencial para alcançar frequências de modulação acima dos 100 GHz, o que permitirá que ele cumpra o seu papel, até agora apenas teorizado, de ampliar as larguras de banda nas telecomunicações.

A transmissão óptica de dados por laser é um pré-requisito básico das telecomunicações ópticas. Mas a frequência de modulação típica dos lasers atuais está por volta dos 50 GHz.

Enquanto nos lasers convencionais o spin dos elétrons injetados é inteiramente arbitrário, em um laser spintrônico somente são usados elétrons com um spin determinado previamente.

Usando esses elétrons polarizados pelo spin, o laser é forçado a trabalhar simultaneamente em dois modos, cada um em uma frequência diferente.

Quando os dois modos de laser são acoplados no mesmo ressonador, surge uma oscilação com uma nova frequência, que pode teoricamente superar em muito os 100 GHz.

Como a duração dessas oscilações pode ser ajustada por meio da corrente, esses lasers de spin são ideais para a transmissão óptica de dados.

“Esta diferença de frequência pode ser facilmente ajustada usando a chamada birrefringência no ressonador, por exemplo, simplesmente curvando o microlaser,” explica o Dr. Nils Gerhardt, principal autor do trabalho.

O primeiro protótipo – funcionando a temperatura ambiente – atingiu uma frequência de oscilação de 11,6 GHz, bem acima dos 4 GHz observados no próprio dispositivo.

Como já há lasers de modo único operando na faixa dos 50 GHz, é fácil ver o potencial do novo dispositivo.

Leis da Física variam ao longo do Universo

Os cientistas usaram quasares, gigantescos núcleos galáctivos muito brilhantes e muito distantes da Terra, para iluminar os átomos dispersos pelo espaço. Analisando a luz que nos chega, eles concluíram que esses átomos se comportam de forma diferente dos átomos na Terra. - Imagem: Michael Murphy/Swinburne University of Technology/NASA/ESA

Um dos mais queridos princípios da ciência – a constância das leis da física – pode não ser verdadeiro.

Um estudo publicado na mais conceituada revista de física, a Physical Review Letters, afirma que as leis da natureza podem variar ao longo do Universo.

O estudo concluiu que uma das quatro forças fundamentais, o eletromagnetismo, parece variar de um lugar para outro.

O eletromagnetismo é medido por meio da chamada constante de estrutura fina, simbolizada pela letra grega alfa (α).

Esta constante é uma combinação de três outras constantes: a velocidade da luz (c), a carga do elétron (e) e a constante de Planck (h), onde α = e2/hc.

O resultado é cerca de 1/137, um número sem dimensão, o que a torna ainda mais fundamental do que as outras constantes, como a gravidade, a velocidade da luz ou a carga do elétron.

Em termos gerais, a constante alfa mede a magnitude da força eletromagnética – em outras palavras, a intensidade das interações entre a luz e a matéria.

Agora, John Webb e seus colegas das universidades de Nova Gales do Sul e Swinburne, na Austrália, e Cambridge, no Reino Unido, mediram o valor de alfa em cerca de 300 galáxias distantes, usando dados do Very Large Telescope do ESO, no Chile.

“Os resultados nos deixaram estupefatos,” disse o professor Webb. “Em uma direção, a partir de nossa localização no Universo, a constante alfa vai ficando gradualmente mais fraca, e gradualmente mais forte na direção oposta.”

Isso mostra uma espécie de “eixo preferencial” para o Universo – chamado pelos cientistas de “dipolo australiano” – de certa forma coincidente com medições anteriores que deram origem à teoria do chamado Fluxo Escuro, que indica que uma parte da matéria do nosso Universo estaria vazando por uma espécie de “ralo cósmico”, sugada por alguma estrutura de um outro universo.

“A descoberta, se confirmada, terá profundas implicações para o nosso entendimento do espaço e do tempo, e viola um dos princípios fundamentais da teoria da Relatividade Geral de Einstein,” completou Webb, referindo-se ao princípio da equivalência de Einstein.

Naquele momento, porém, o estudo ainda não havia sido publicado em uma revista revisada pelos pares – tanta demora para que outros cientistas analisassem o estudo é uma indicação bem clara do impacto que os resultados podem ter sobre todo o edifício científico estabelecido.

O Dr. Webb e seus colegas vêm trabalhando no assunto há muito mais tempo. Seus primeiros resultados vieram em 1999, mas eram baseados em um número menor de galáxias, de uma região mais restrita do céu.

Uma das implicações dessas “constantes inconstantes” é que o Universo pode ser infinito.

“Essas violações são de fato esperadas por algumas ‘teorias de tudo’, que tentam unificar todas as forças fundamentais. Uma alteração suave e contínua de alfa pode implicar que o Universo seja muito maior do que a parte dele que conseguimos observar, possivelmente infinito,” propõe o Dr. Victor Flambaum, coautor do estudo.

Outra possibilidade derivada dessa variação na constante alfa é a existência de multiversos, múltiplos universos que podem, de alguma forma, “tocar-se” uns aos outros.

O professor Webb afirma que esta descoberta também pode dar uma resposta muito natural para uma questão que tem intrigado os cientistas há décadas: por que as leis da física parecem tão bem ajustadas para a existência da vida?

“A resposta pode ser que outras regiões do Universo não são tão favoráveis à vida como nós a conhecemos, e que as leis da física que medimos em nossa parte do Universo são meramente ‘regras locais’. Neste caso, não seria uma surpresa encontrar a vida aqui,” afirma o cientista.

Isto porque basta uma pequena variação nas leis da física para que, por exemplo, as estrelas deixem de produzir carbono, o elemento básico da “vida como a conhecemos”.

Para chegar às suas conclusões, os cientistas usaram a luz de quasares muito distantes como faróis.

O espectro da luz que chega até nós, vinda de cada quasar, traz consigo sinais dos átomos nas nuvens de gás que a luz atravessou em seu caminho até a Terra.

Isto porque uma parte da luz é absorvida por estes átomos, em comprimentos de onda específicos que revelam a identidade desses átomos – de quais elementos eles são.

Essas “assinaturas espectrais”, chamadas linhas de absorção, são então comparadas com as mesmas assinaturas encontradas em laboratório aqui na Terra para ver se a constante alfa é mesmo constante.

Os resultados mostraram que não, que alfa varia ao longo de um eixo que parece atravessar o Universo, assim como um eixo magnético atravessa a Terra.

Quanto ao espanto causado pelos resultados, o Dr. Webb afirma que as chamadas leis da física não estão “escritas na pedra”.

“O que nós entendemos por ‘leis da natureza’? A frase evoca um conjunto de regras divinas e imutáveis que transcenderiam o ‘aqui e agora’ para aplicar-se em todos os lugares e em todos os tempos no Universo. A realidade não é tão grandiosa.

“Quando nos referimos às leis da natureza, estamos na verdade falando de um determinado conjunto de ideias que são marcantes na sua simplicidade, que parecem ser universais e que têm sido verificadas por experimentos.

“Portanto, somos nós, seres humanos, que declaramos que uma teoria científica é uma lei da natureza. E os seres humanos frequentemente estão errados,” escreveu ele em um artigo na revista Physics World.

Reação muito semelhante teve um dos pesquisadores responsáveis pelo recente experimento que teria identificado neutrinos viajando a velocidades superiores à da luz, outro achado que contraria as atuais leis da física.

Ao falar sobre a controvérsia e as inúmeras tentativas de dar outras explicações para os resultados, o Dr. Sergio Bertolucci afirmou que “um experimentalista tem que provar que uma medição está certa ou está errada. Se você interpretar cada nova medição com as velhas teorias, você nunca terá uma nova teoria”.

E como os cientistas poderão ter certeza de que é hora de investir em uma nova teoria?

Se há variação em uma das constantes, é de se esperar que as outras constantes fundamentais também variem.

Tudo o que eles terão que fazer será projetar experimentos que possam verificar variações na gravidade, na carga do elétron ou na velocidade da luz.

2011 11 18

Será necessário descartar a teoria do Big Bang?

Um grupo de físicos portugueses está propondo que o Sol seja usado para testar algumas teorias alternativas à Teoria da Relatividade Geral de Einstein.

Jordi Casanellas e seus colegas da Universidade Técnica de Lisboa afirmam que uma teoria proposta há mais de um século por Arthur Eddington não foi totalmente descartada pelas observações recentes dos neutrinos solares e das ondas acústicas solares.

E, segundo eles, uma variante da teoria de Eddington pode ajudar a resolver algumas das deficiências das teorias atuais.

A Teoria da Relatividade Geral, que descreve a gravidade como a curvatura do espaço-tempo por corpos celestes de grande massa, tem passado por todos os testes aos quais tem sido submetida ao longo dos anos.

Mas isto não significa que ela não tenha problemas.

Além da bem conhecida dificuldade de unificação com a mecânica quântica e das ainda pendentes explicações para a matéria e a energia escuras, há o problema bem mais sério das singularidades, onde as leis da física simplesmente se esfacelam.

Em 2010, Máximo Bañados (Universidade Católica do Chile) e Pedro Ferreira (Universidade de Oxford) propuseram uma variante da teoria de Eddington que adiciona um termo gravitacional repulsivo para a teoria da relatividade.

Mas o que parece ser a simples adição de mais um membro a uma equação tem um efeito devastador sobre o entendimento mais geral do cosmo.

Esse termo gravitacional repulsivo não apenas elimina a necessidade das singularidades – ele descarta a formação dos buracos negros e a ideia de que o Universo teria surgido de um Big Bang.

Quando tenta interpretar um campo gravitacional em um vácuo, essa teoria inspirada em Eddington é equivalente à teoria da relatividade. Mas ela prevê efeitos diferentes para a gravidade agindo no interior da matéria.

O lugar ideal para testar essas diferenças seria o interior de estrelas de nêutrons.

Embora se acredite que estrelas de nêutrons possam acordar o vácuo quântico, não se sabe o suficiente a respeito delas para comparar as duas teorias. Por exemplo, recentemente foi encontrada uma estrela de nêutrons cuja existência os astrônomos acreditavam ser impossível.

Entra em cena então a proposta de Casanellas e seus colegas portugueses: usar o Sol.

Mesmo sendo uma fonte de gravidade muito menos extrema do que uma estrela de nêutrons, o funcionamento do interior do Sol já é razoavelmente bem descrito pelos modelos solares.

O grupo de Casanellas calculou que, mesmo em sua forma newtoniana, não-relativística, a teoria derivada de Eddington prevê diferenças quantificáveis nas emissões solares em comparação com a teoria gravitacional padrão, desenvolvida por Einstein.

Constante gravitacional na matéria

O termo gravitacional repulsivo na teoria de Bañados e Ferreira, afirmam eles, seria equivalente a dar um valor diferente para a constante gravitacional no interior da matéria.

E intensidades diferentes da gravidade no interior do Sol devem resultar em diferenças em sua temperatura interna, uma vez que se assume que o Sol está em equilíbrio hidrostático – a pressão para dentro de sua massa é equilibrada pela pressão para fora gerada pelas reações de fusão nuclear em seu interior.

Uma temperatura mais elevada implica uma maior taxa de fusão nuclear, o que, por sua vez, implica em uma maior taxa de emissão de neutrinos solares, algo diretamente mensurável.

E não apenas isso: uma força da gravidade maior no interior do Sol implica em uma variação na sua distribuição de densidade, o que deve modificar a propagação das ondas acústicas em seu interior, o que pode ser medido com as técnicas da heliossismologia.

Todos esses dados já estão disponíveis. Contudo, eles colocam sérias restrições à nova teoria, impondo limites muito estreitos para seus valores.

Mas não a descartam, afirmam os pesquisadores, salientando que os dados apenas colocam limites para a nova teoria.

Um teste mais rigoroso exigiria melhorias nos modelos solares, incluindo a abundância de hélio na superfície do Sol, ou medições mais precisas dos fluxos de neutrinos.

Para apenas fazer o teste já é por si um enorme avanço, demonstrando que nossa estrela – tão pequena em termos cósmicos – pode ser usada para fazer experimentos de teorias com potencial de explicação em termos universais.

Paolo Pani, um dos membros da equipe, sugere um teste alternativo, aqui na Terra mesmo.

Para ele, tanto a teoria derivada de Eddington, quanto outras teorias alternativas da gravidade, poderiam ser testadas medindo a atração gravitacional entre uma esfera de metal inserida em um buraco no solo e a massa da Terra ao seu redor.

A ideia é fazer um buraco onde coubesse apenas a esfera, e nada mais, com uma precisão gigantesca, de forma que a medição mostrasse apenas a intensidade da gravidade no interior da matéria, e não no vazio ao seu redor – no caso, no ar.

Entretanto, o próprio Pani concorda que projetar esse experimento apresenta desafios consideráveis.

Não poderia ser diferente para alguém que tenha a pretensão de desbancar uma das teorias de maior sucesso até hoje.

2011 11 18

Apple faz recall de iPod nano

A Apple admitiu que alguns aparelhos iPod nano de primeira geração, comercializados entre 2005 e 2006, apresentam problemas de superaquecimento e devem ser substituídos.

A empresa orienta que os proprietários deixem de utilizar o aparelho e providenciem sua substituição pelo site http://www.apple.com/support/ipodnano_replacement/

Segundo a empresa, em tradução livre ao texto “Apple determinou que, em casos muito raros, a bateria do iPod nano (primeira geração) pode superaquecer e representam um risco de segurança. IPod nanos afetados foram vendidos entre setembro de 2005 e dezembro de 2006.”

Ainda: “Esta questão tem sido atribuída a um fornecedor da bateria única que produziu as baterias com defeito de fabricação. Embora a possibilidade de um incidente é raro, a probabilidade aumenta com o envelhecimento da bateria.”

Novela – HP mantém divisão de PCs

A HP voltou atrás e disse que não venderá mais a sua divisão de computadores pessoais.

Em agosto, a HP anunciou que iria se desfazer (ou dividir) da divisão de PCs para se concentrar em outras áreas mais rentáveis. Acontece que dos US$ 126 bilhões faturados pela HP, US$ 40 bilhões são provenientes das vendas de PCs.

Dizer que este segmento, que representa mais de um terço do faturamento total da empresa, não é rentável, a HP só pode estar brincando.

“Queremos nos expandir em software, mas ainda não terminamos com o hardware. Há muitas oportunidades a explorar”, disse Meg Whitman, CEO da HP.

Depois de tanta novela a HP decidiu voltar atrás: continuará com sua divisão de PCs. Não só PCs, mas também deverá produzir tablets com Windows 8, para surpresa de muitos – talvez o WebOS volte, mas é provável que não. Recentes boatos de que a HP estaria testando o Windows 8 no Touchpad parecem ser bem verdadeiros agora.

Meg Whitman, CEO da empresa, afirmou que não faz sentido separar a divisão de PCs da HP – a divisão é a PSG, Personal Systems Group, como é chamada por lá.

A separação não criaria retorno suficiente para os acionistas, nem valor para os clientes. O resultado poderia ser decepcionante, já que os custos e riscos da separação seriam maiores do que os que a empresa poderia lidar.

Mais detalher em: http://www.hp.com/hpinfo/newsroom/press/2011/111027xa.html

Sobre os tablets, ela comentou “Acho que devemos estar no mercado de tablets, e certamente iremos para ele com o Windows 8”. É, 2012 logo está aí… Leo Apotheker (ex-CEO) deve estar louco agora.

Fonte: Clube do Hardware; http://www.hp.com/hpinfo/newsroom/press/2011/111027xa.html; http://www.hardware.com.br/noticias/2011-10/divisao-pcs.html

2011 11 01